AI都学会和人类谈判了?还能成功说服人类听它安排?

话术一流到人类完全分辨不出它是AI。

这就是Meta AI的最新成果——AI模型CICERO(西塞罗),现已登上Science。

嗯,就是和古罗马著名政治家、演说家西塞罗同名。

研究人员让这个AI西塞罗隐藏身份加入到一个外交游戏里,82名人类玩家在40场游戏中,都没有怀疑过它其实是个AI。

而且还战绩斐然,全程平均分达到25.8%,是人类玩家平均分的2倍,并且最终排名为前10%。

成果一经发布,就在网上引发热议。

有人评价:这意味着AI在最具人类特点的游戏里战胜人类,超乎想象…

LeCun都称它为:里程碑式的研究!

目前,模型代码已在GitHub上开源。

真有AI纵横家那感觉了

AI唠嗑其实一直都引人诟病,更别提外交这种需要超高话术的场景了。

它需要理解对方的语言、动机,制定自己的话术策略,并调整好措辞。

有时甚至还需要“耍心眼”,故意说一些假话给对方设套。

这种超高难度任务,怎么挑战?

俗话说一口吃不成胖子。

Meta AI就想到了先从游戏场景来切入(毕竟AI在玩游戏上是老手了)。

不过和之前棋类或竞技游戏不同,外交游戏并没有那么强的规则性,运筹帷幄、随机应变的环节不少。

实验中用到的游戏是webDiplomacy(以下用“外交游戏”指代它)。

这款游戏的背景是1901年的欧洲,7位玩家每人控制一个大国,通过相互合作、协商,尽可能地占领更多领土。

西塞罗的核心是由一个对话引擎和一个战略推理引擎共同驱动的。

简单理解,这里的对话引擎和GPT-3、LaMDA类似,战略推理引擎和AlphaGo相近。

用到的对话模型,是从一个类似于2.7亿参数的BART模型训练而来。

BART吸收了GPT和BERT各自的特点,它比BERT更适合文本生成的场景,还能双向理解上下文语境信息。

具体来看,研究人员先从互联网上获取文本训练对话模型,然后再在实际的外交游戏场景中微调。

战略推理引擎用到的是一个规划算法(planning algorithm)。

该算法能够基于现况计算出一个最优选择。再通过强化学习训练,惩罚模型做出的“不像人”的策略,以此让模型给出的策略更合理。

毕竟,在外交游戏中是和人打交道,让AI更像人也是最基本的要求之一。

而且强化学习这种迭代式的训练,可以不断改进AI做出的策略预测。比传统方法中常用的监督学习(即打标签的方式)效果更好。

实操中,西塞罗首先会根据目前为止的游戏状态和对话,对每个人的会采取的动作做一个初步预判。

接下来,在不断地协商过程中,它都会不断地改进预测,然后使用这些预测为自己和合作伙伴设置一个共同的目标。

其次,它会根据局势状态、对话及其目标,从对话模型中生成几个候选消息,使用分类器等过滤机制过滤掉无意义的,生成最终的高质量输出文本。

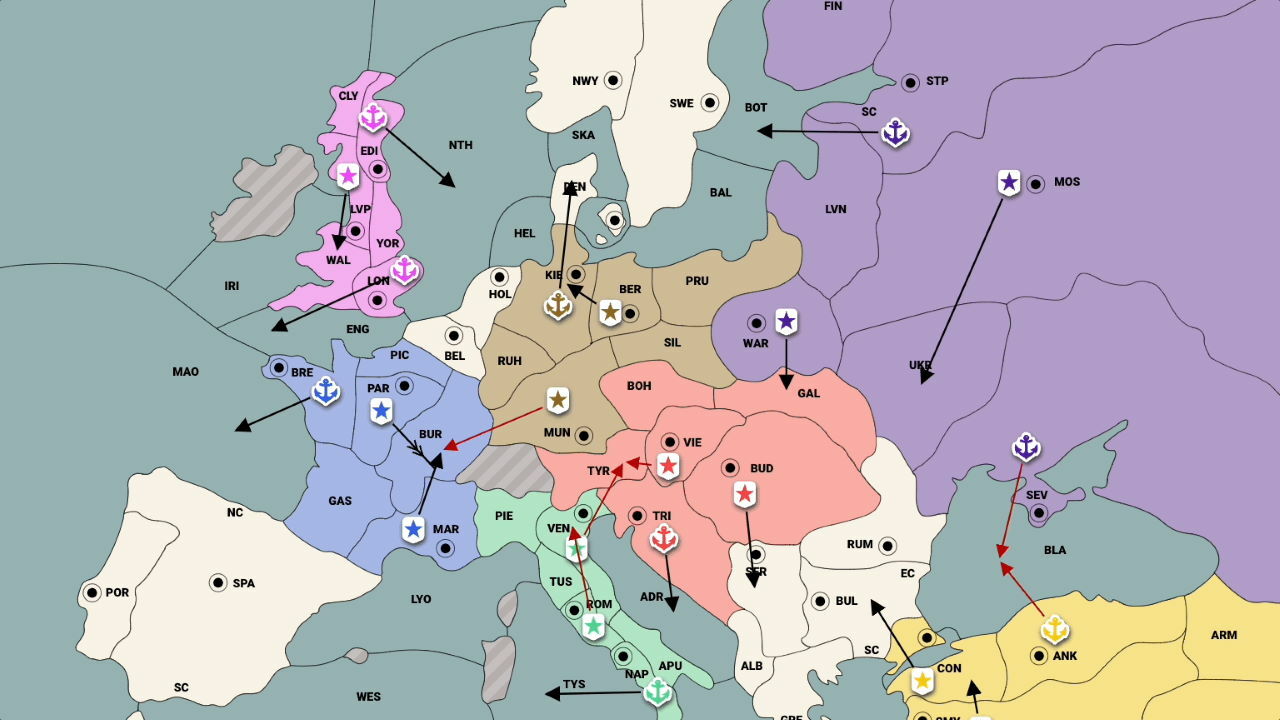

例如,以下图为例,在这一局中,西塞罗扮演“奥地利”。

当玩家“意大利”向它询问意见,自己是否应该攻击土耳其时,西塞罗会根据场上局势——土耳其正在攻击俄罗斯,判断出这是一个两面夹击的好机会,然后劝意大利跟进攻打土耳其。

这一步既建立了与意大利的伙伴关系,又消灭了一个潜在的对手。

不仅如此,谈判也是西塞罗的拿手好戏。

这次西塞罗扮演的是“德国”,与玩家“法国”一直在交战。这时法国南部同时受到了意大利的攻击,于是向西塞罗请求和谈。

西塞罗则趁机狮子大开口,要求法国归还侵略的领土,并保证不攻击荷兰。双方在讨价还价中顺利达成了协议。

就像上述展示的例子一样,两个月间,西塞罗共参与了40场外交游戏,与82名人类参赛者交锋。

在每场比赛中,西塞罗都会发送和接收平均130条消息。

其游戏水平甚至强过了人类:平均得分是人类玩家的2倍以上,甚至在玩过一场以上游戏的参与者中也能排到前10% 。

网友:虽然它表现好但我很害怕

看完西塞罗在外交上的精彩表现,有网友感慨AI的发展速度:

Deep Blue击败了卡斯帕罗夫,Watson击败了智力竞赛的两位人类冠军,现在轮到Meta AI敲响马基雅维利(近代政治思想奠基人)的大门了。

还有人表示,这难道是迈向通识语言大模型的第一步吗?

LeCun给出了肯定回复:

至少语言是基于事实的。

不过由于这款外交游戏以尔虞我诈著称,不少人也对此表示担忧:

这是直接鼓励研究人员开发更多擅长骗人的模型。

有网友就表示,玩这游戏甚至会失去朋友哦。

而从AI西塞罗的战绩来看,它可以迷惑人类玩家,并且说服人类听从它的策略。

所以有人就表示,这不是AI控制人类的选择乃至生活?

不过Meta AI表示,AI西塞罗不是全没有失误的。

并且游戏中也还有很多需要和人类协作的环节,西塞罗的表现同样很好。

目前,它还只被放在游戏场景中测试过,并没有尝试过在开放语境下和人类谈判。

来源:https://www.toutiao.com/article/7169065509785174539/